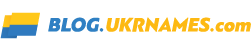

C моменту своєї появи в грудні 2017-го діпфейки, відео з майже ідеальною заміною особи, створені нейромережею, наводили на експертів паніку. Багато хто, наприклад, тоді боялися, що тепер ще простіше стане «порно-помста», коли колишній бойфренд з досить потужним ПК може змайструвати будь-яке брудне порно з подругою. А Наталі Портман і Скарлетт Йоханссон, про яких порно з deepfake знімали особливо багато, публічно прокляли інтернет.

Щоб боротися з підступаючю загрозою, Facebook і Microsoft недавно зібрали коаліцію для боротьби з діпфейками, оголосивши призовий фонд $10 млн тим розробникам, які придумають кращі алгоритми для їх виявлення. Це окрім DARPA, управління дослідженнями Міністерства оборони США, який виділив на цю мету $68 млн за останні два роки.

Проте, вже пізно. Перший deepfake-злочин вже відбувся.

За даними Wall Street Journal, в березні цього року керуючий директор британської енергетичної компанії був пограбований на €220 000 (близько $240 000). Він відправив ці гроші фірмі-постачальнику з Угорщини, тому що його бос, глава материнської фірми в Німеччині, кілька разів підтвердив йому таку інструкцію. Але насправді якийсь хитрий зловмисник просто використовував софт з AI-технологіями, щоб в режимі реального часу замінювати особу і голос керівника, і вимагати, щоб той заплатив йому протягом години.

Програма, яку використовував злодій, змогла повністю імітувати голос людини: тон, пунктуацію, навіть німецький акцент. Повідомлення виходило з адреси боса в Німеччині, на підтвердження британському директору був направлений e-mail з контактами. Припустити, що щось йде не так, можна було хіба що на вимогу боса провести всю операцію якомога швидше, але це далеко не перший аврал, який траплявся в їх бізнесі.

У підсумку – все гроші пропали. З угорського аккаунта їх перевели в Мексику, а потім розвіяли по всьому світу. Але злодії на цьому не зупинилися. Вони попросили другий терміновий переклад, щоб «поставки з Угорщини» «пішли ще швидше». Тут вже британський директор відчув недобре, і подзвонив своєму справжньому босові. Вийшов якийсь сюр: він по черзі брав дзвінки то від фейкового, то від справжнього керівника, говорять однаковими голосами. Назва компанії та її співробітників не розголошуються, оскільки у цій справі ведеться розслідування, і злодії ще не знайдені.

Можливо, це навіть не перша крадіжка з використанням Deepfake AI (або його просунутих послідовників). Symantec повідомляє, що вона засікла як мінімум три випадки, в яких заміна голосу допомогла злодіям обхитрити компанії і змусити їх послати їм гроші. В одному з цих випадків збиток склав мільйони доларів. Причому, судячи за непрямими ознаками, цей трюк був проведений іншими зловмисниками – не тими, які обікрали британського СЕО. Тобто, deepfake-злочини поступово стають загальним надбанням, це не вигадка якогось одного геніального хакера.

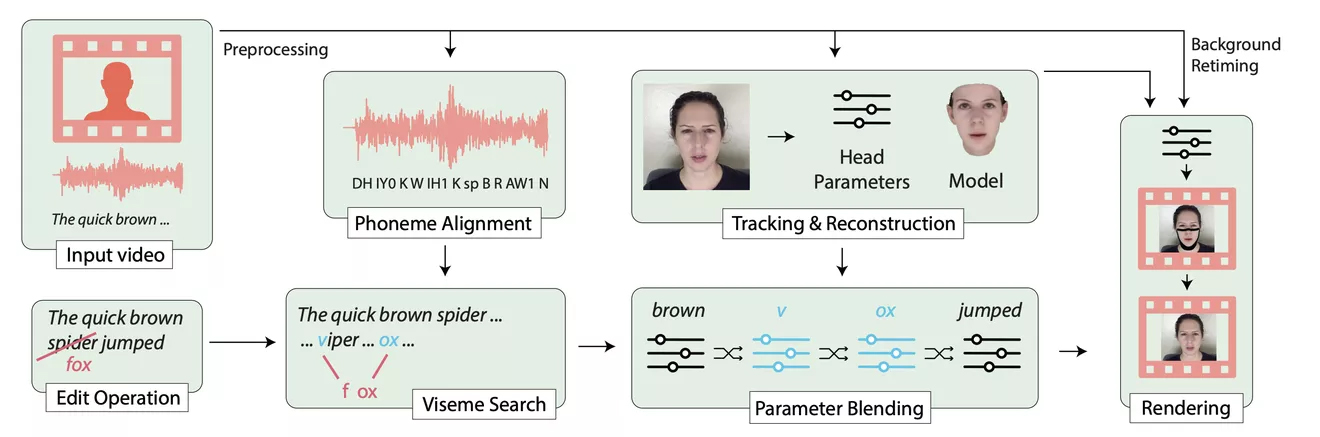

Насправді, скоро таку процедуру зможе виконати будь-який школяр. Головне – знайти досить довірливу жертву, і зібрати потрібну кількість семплів відео/аудіо, щоб імперсонувати, кого потрібно. Google Duplex вже успішно мімікрують під голос реальної людини, щоб робити дзвінки від його імені. Багато невеликих стартапів, в основному з Китаю, працюють над тим, щоб пропонувати схожі на deepfake сервіси безкоштовно. Різні програми-діпфейки навіть змагаються один з одним, хто зможе згенерувати достатньо переконливе відео з людиною, використовуючи мінімальний обсяг даних. Деякі заявляють, що скоро їм буде досить одного вашого фото.

У липні Ізраїльське національне управління захисту від кіберзагроз випустило попередження про принципово новий вид кібератак, які можуть бути спрямовані на керівництво компаній, відповідальних співробітників і навіть високопоставлених чиновників. Це перша і на даний момент сама реальна AI-загроза. Вони кажуть, вже зараз є програми, здатні ідеально передати ваш голос і акцент, прослухавши вас 20 хвилин. Якщо десь в мережі є запис з вашою промовою протягом півгодини, або якщо хтось трохи посидів поруч з вами в кафе з диктофоном, ваш голос тепер може бути використаний, щоб сказати кому завгодно що завгодно.

Поки що інструментів для боротьби з цим немає. Варіант захиститися тільки один. Якщо вам хтось дзвонить і просить перевести значну суму грошей, – не буде зайвим підтвердити, що це той самий чоловік, по іншому каналу. Через месенджери, Скайп, e-mail, корпоративні канали або соцмережі. А в ідеалі, звичайно ж, – лицем до лиця.

Ну а якщо у вас є глибокі пізнання в машинному навчанні і ви не проти отримати шматок від пирога в $10 млн – можна спробувати себе в конкурсі Microsoft і Facebook. Або заснувати свій стартап, що пропонує державі і солідним компаніям бізнес-рішення для визначення діпфейків за картинкою або за голосом. Без цього нам скоро буде не обійтися.

Джерело: habr.com