Останнім часом завдяки технологіям машинного навчання дослідники Google досягли помітних успіхів в області розуміння мови, і пошуковик став набагато краще обробляти запити. Відзначається, що зроблений найбільший прорив за останні п’ять років і один з найбільш грандіозних успіхів за всю історію Google Пошуку.

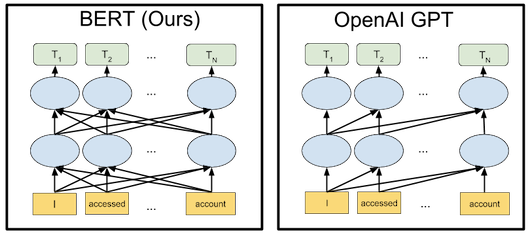

У минулому році компанія у відкритому доступі представила технологію попереднього навчання обробки тексту на природній мові (NLP), розроблену на базі нейронних мереж. За допомогою BERT (Bidirectional Encoder Representations from Transformers) кожен може навчити власну сучасну питально-відповідну систему.

Цей прорив стався завдяки вивченню трансформерів – моделей, які обробляють слова не як послідовність розрізнених мовних одиниць, а враховують в реченні взаємодію слів один з одним. Тому моделі BERT можуть обробляти не тільки окремі слова, а й розуміти контекст, в якому вони вживаються. Це особливо важливо для розуміння справжнього змісту пошукових запитів.

Але для вирішення поставленого завдання потрібні не тільки нові програми, компанії не вистачало і технічної складової. Деякі моделі, які можна створити за допомогою BERT, настільки складні, що наявне навіть в розпорядженні Google устаткування з ними не справлялося. Тому в компанії вперше стали використовувати тензорні процесори (TPU), за допомогою яких можна швидко підібрати для користувача більш актуальну інформацію.

Тепер обробляючи стандартні і виділені описи за допомогою моделей BERT, вдається набагато краще справлятися з пошуком потрібної інформації. Якщо говорити про стандартні описи, то BERT допомагає Google краще розуміти кожен 10-й англомовний запит в США. В основному Google Пошук стане ефективніше для довгих і розмовних запитів, а також запитів з прийменниками. Тепер пошукова система буде краще розуміти контекст і показувати відповідні результати, а значить ви зможете використовувати більш природні запити.

Але BERT використовується не тільки для англійської, а й для інших мов. Створені на його основі системи хороші тим, що вони можуть застосувати принципи, яким навчилися на одній мові, до інших.

Повідомляється, що цього місяця моделі BERT стануть доступні для запитів російською мовою.

“Людська цікавість не знає меж. Щодня ми бачимо мільярди пошукових запитів, і 15% з них – абсолютно нові. Щоб обробляти такі запити, ми створили нові інструменти”, зазначив Панду Найак, віце-президент Google Пошуку.

Джерело: ko.com.ua